W dzisiejszym krajobrazie bezpieczeństwa infrastruktury, brak zaufania oznacza wiele rzeczy dla różnych ludzi. Kiedy się nad tym zastanowić, nie jest to zbyt wielkim zaskoczeniem, biorąc pod uwagę, że nie jest to pojedynczy produkt ani „stos”. W rzeczywistości zerowe zaufanie to trzy rzeczy u podstaw. Po pierwsze i najważniejsze, jest to strategia, która dyktuje postawę, jaką należy przyjąć przy próbach uzyskania dostępu do aplikacji i zasobów sieciowych - niezależnie od źródła. Po drugie, jest to architektura i podejście do sposobu rozmieszczenia elementów w sieci, środowisku aplikacji i tożsamości w celu poprawy stanu bezpieczeństwa dzięki domyślnemu modelowi „bez zaufania”. Po trzecie, jest to model kontekstowy, który usuwa binarne podejmowanie decyzji o przyznaniu aplikacji i działań usługowych, biorąc pod uwagę warunki żądania. Zasady koncentrują się na założeniu, że wszystkie podmioty próbujące uzyskać dostęp mogą stanowić zagrożenie - wewnętrzne lub zewnętrzne. Prowadzi to do weryfikacji pierwszego i zapewnienia ograniczonego dostępu (z podejrzeniem) do drugiego modelu.

Gdybyś próbował chronić cenny zasób fizyczny, nie kładłbyś czerwonego dywanu od wejścia do budynku, który go zawiera, prosto do sekretnych drzwi, w których się znajduje. Jest to jednak typowe podejście w przypadku opublikowanych aplikacji. Ścieżki do miejsc, w których istnieją te usługi, są łatwe do zidentyfikowania, a w niektórych przypadkach są reklamowane. Dopiero przy próbie uzyskania dostępu następuje pewnego rodzaju weryfikacja, czy łączący się podmiot ma jakąś potrzebę biznesową, aby uzyskać dostęp do usługi, czy nie.

Podejście oparte na zerowym zaufaniu ma na celu odwrócenie tego modelu do góry nogami poprzez próbę wykrycia intencji łączącego się podmiotu na wcześniejszym etapie przepływu i podjęcie decyzji, czy dalsza komunikacja jest prawidłowa, czy nie, przed umożliwieniem bliższego dostępu do chronionej usługi.

Tradycyjne modelowanie bezpieczeństwa

W tradycyjnym modelu bezpieczeństwa sieci często stosowano podejście oparte na „zamku”, w którym zbudowano silne mury obronne, i „fosie”, w którym zakładano, że wszystko na zewnątrz jest niebezpieczne, dopóki nie zostanie udowodnione inaczej, a wszystko wewnątrz murów uznano za bezpieczne, dopóki nie zostanie udowodnione inaczej. To samo w sobie było zbudowane na fałszywej logice, biorąc pod uwagę, że zawsze istniały wektory ataku, które mogłyby zostać użyte przez złego aktora. Na przykład, jeśli frontendowe serwery WWW, które odpowiadały na prawidłowo wynegocjowane sesje, istniały w strefie DMZ i miały jakiś łańcuchowy dostęp do innych zasobów wewnętrznych, można to wykorzystać. Jeśli środowisko miało serwery bramy poczty e-mail, które mogłyby służyć jako przekaźnik lub przynajmniej akceptowały wiadomości e-mail (niektóre potencjalnie złośliwe), zapewniało to kolejne drzwi przez mury zamku bezpośrednio do użytkowników, ich urządzeń i dostępu, jaki mają do systemów i danych. Co więcej, logika silnej granicy uległa dalszemu osłabieniu, ponieważ użytkownicy, urządzenia i dane często i tak żyją teraz poza granicami sieci w lokalizacji. Trendy BYOD, WFH, mobile i SaaS ostatecznie stworzyły nowy paradygmat, który zostanie z nami. Podmioty chmurowe, mobilne i IoT często znajdują się poza granicami zapory i jako takie wymagane są kontrole tożsamości i dostępu, które zapewniają spójność zarówno w środowisku lokalnym, jak i w chmurze.

Zero zaufania - nowy paradygmat

W świetle tego wszystkiego, nic dziwnego, dlaczego sprawdza się modele alternatywne. Bezpieczeństwo IT stało się bardziej złożone niż kiedykolwiek, a exploity bardziej wyrafinowane. W wielu środowiskach starsza infrastruktura jest zlokalizowana obok mniej bezpiecznych technologii IoT. Zagrożenia zero-day i udane ataki polimorficzne gwałtownie wzrosły, a więcej ataków niż kiedykolwiek ma charakter oparty na tożsamości. Tu właśnie bryluje zerowe zaufanie - zakładając, że każdy klient może stanowić zagrożenie, duży nacisk kładzie się na kontekst i sygnały w celu określenia wyniku decyzji o dostępie. Tylko dlatego, że wprowadzono poprawną nazwę użytkownika i hasło, nie oznacza, że dostęp do aplikacji powinien być zawsze przyznawany i o to właśnie chodzi… Lokalizacja segmentu sieci, informacja do czego następuje próba dostępu i inne czynniki, które mają znaczenie, powinny być brane pod uwagę w przypadku modelu just-in-time i wystarczającego dostępu (just-enough-access), opartego na silnej polityce bezpieczeństwa.

Chociaż zerowe zaufanie nie jest nową koncepcją sieciową, dopiero niedawno znalazło się na torze masowej adopcji. Zgodnie z zasadami architektury kontroli dostępu do sieci (NAC) z 2004 roku, firma Forrester ukuła termin „Zero Trust” i po raz pierwszy opublikowała na łamach BeyondCorp w 2014 roku. Zdefiniowana programowo grupa robocza Cloud Security Alliance również przyczyniła się do rozwoju koncepcji związanej z zerowym zaufaniem. W ciągu ostatniego roku National Institute of Standards and Technology (NIST) opublikował również dokument SP 800-207 Zero Trust Architecture, mający na celu opisanie środowiska zerowego zaufania dla architektów bezpieczeństwa w przedsiębiorstwach i służący jako środek do zrozumienia tego podejścia.

Oczekuje się, że wszystkie te czynniki jeszcze bardziej zwiększą przyjmowanie podejścia zerowego zaufania do bezpieczeństwa aplikacji w organizacjach.

Jak Kemp pomaga klientom osiągnąć cele zerowego zaufania

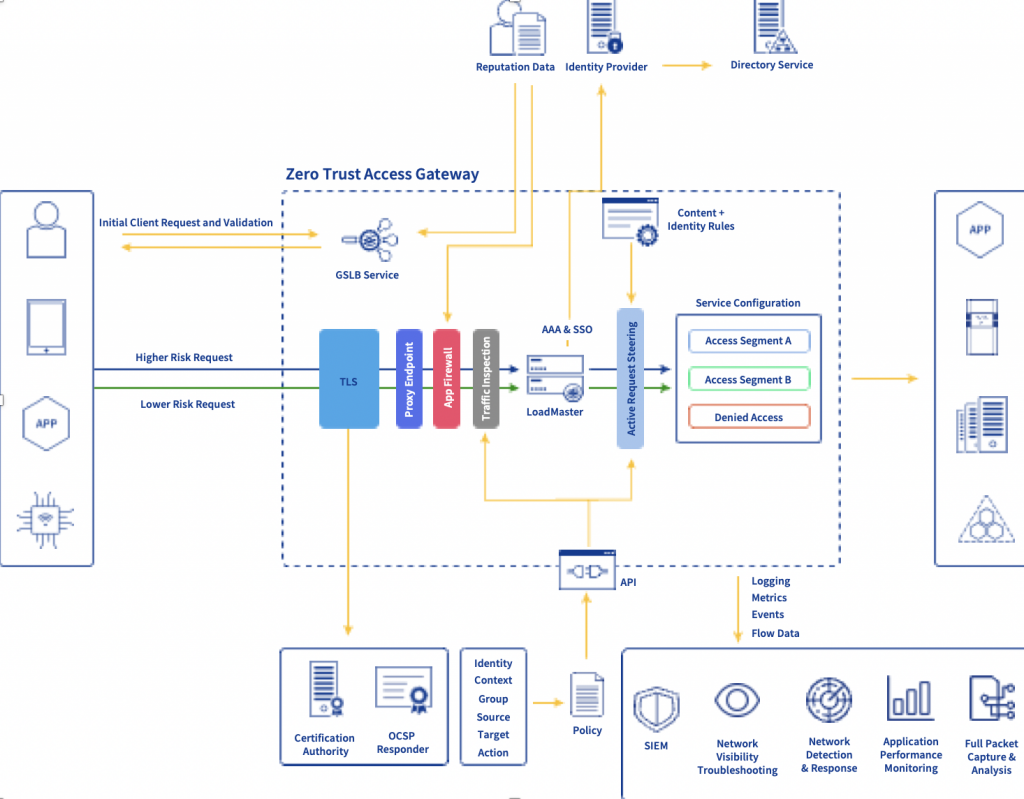

Ze względu na ogromne zainteresowanie klientów, cieszymy się, że możemy wprowadzić naszą nową architekturę bramy dostępu zerowego zaufania, która umożliwia klientom uproszczenie stosowania złożonych zasad dostępu do opublikowanych aplikacji i usług. Nasze doświadczenie w zakresie application proxy do zaawansowanego sterowania ruchem i wstępnego uwierzytelniania stawia nasze zaawansowane moduły równoważenia obciążenia aplikacji w najlepszej pozycji do promowania strategii zerowego zaufania.

Podobnie jak systemy równoważenia obciążenia są często wykorzystywane do konsolidacji zarządzania certyfikatami, głębokiej inspekcji pakietów i zapór na poziomie aplikacji, uprzywilejowana pozycja ruchu przychodzącego i wychodzącego jest również optymalna do wymuszania zasad dostępu. Nasze rozwiązanie obejmuje natywne możliwości publikowania aplikacji w warstwie 7 w połączeniu z integracją iDP i złożoną dystrybucją żądań klientów w oparciu o charakterystykę ruchu. Oznacza to, że można wykorzystać różne warunkowe dane wejściowe, aby zdecydować, czy należy przyznać dostęp do usług z równoważeniem obciążenia, wraz z kontrolą nad tym, jaki typ komunikacji lub działań będzie dozwolony. Segment sieci źródłowej lub to, czy klient jest wewnętrzny, czy zewnętrzny, można wykorzystać do określenia, czy zostaną dostarczone dodatkowe czynniki uwierzytelniania. W przypadku proxy obiektowej pamięci masowej można również dyktować i egzekwować kontrolę nad tym, jakie metody S3 są dozwolone lub nie, i w jakich okolicznościach.

Aby uprościć tworzenie, stosowanie i utrzymanie pożądanych zasad, opracowano infrastructure-as-a-code opartą na opakowaniu PowerShell naszego interfejsu API RESTful. Dzięki temu klienci mogą wykorzystywać pliki definicji do odczytu maszynowego do udostępniania zasad bezpieczeństwa aplikacji. Przykładowe pliki konfiguracyjne zasad zostały opracowane w celu usprawnienia procesu rozpoczynania pracy. Głównym motorem tego podejścia jest pomoc naszym klientom w obniżeniu kosztów wdrożenia, poprawie skalowalności poprzez wyeliminowaniu zadań wykonywanych ręcznie oraz usunięciu niespójności i błędnych konfiguracji - głównych przyczyn pogorszenia działania aplikacji oraz przestojów.

Typowe przypadki użycia

Ogólnie rzecz biorąc, nakreślona filozofia jest często wykorzystywana, aby pomóc klientom w rozwiązaniu problemu z ugruntowanymi przypadkami użycia, takimi jak dostęp do aplikacji dla użytkowników zdalnych, bardziej precyzyjna kontrola dostępu dla użytkowników wewnętrznych i ogólna zgodność ze stanem bezpieczeństwa informacyjnego organizacji. Istnieje wiele tradycyjnych rozwiązań, które mogą rozwiązać niektóre z nich, ale nie zawsze są one odpowiednie. Na przykład niektóre organizacje polegały wyłącznie na dostępie opartym na sieci VPN w celu rozwiązywania scenariuszy ze zdalnymi użytkownikami. Coraz większym problemem związanym z tym podejściem jest fakt, że bez ręcznie utrzymywanych wysoce szczegółowych reguł kontroli dostępu w sieci zazwyczaj możliwe jest boczne przemieszczanie się z niezarządzanych i niezaufanych urządzeń. W scenariuszu BYOD - który staje się coraz bardziej popularny, jeśli urządzenie klienta, nad którym dział IT nie ma kontroli, jest w stanie uzyskać dostęp sieciowy do ekosystemu, niewykluczone, że jeśli takie urządzenie zostanie przejęte, może spowodować wiele szkód. Dzięki systemowemu podejściu, które zapobiega „wędrowaniu” po ekosystemie przez zdalne urządzenia, możliwa jest przede wszystkim poprawa stanu bezpieczeństwa.

Pojawiło się również wiele rozwiązań SaaS opartych na chmurze, których głównym celem jest dołączanie klientów, którzy zaczynają przyjmować zerowe zaufanie. Jednak przejście na te rozwiązania zazwyczaj wymaga fundamentalnej zmiany sposobu projektowania środowiska i dostępu do niego. Chociaż takie rozwiązanie może być celem, często nie jest to pierwszy punkt docelowy. Zamiast tego na drodze do zerowego zaufania często warto ocenić, co już zostało wdrożone, jak można to zorganizować i ponownie rozmieścić, aby rozpocząć transformację organizacyjną.

Jak się tam dostać

Pierwszym krokiem do takiego przejścia jest wstępne zrozumienie obszaru chronionego, a następnie zrozumienie sposobu, w jaki komunikują się dziś aplikacje, klienci i usługi. To w połączeniu z inwentaryzacją istniejących potencjalnych punktów kontrolnych w środowisku napędza architekturę dostosowanego podejścia do Twojego unikalnego ekosystemu. W tym momencie klienci często oceniają, co mogą selektywnie wprowadzić, aby przyspieszyć drogę do zerowego zaufania, na przykład identyfikacja w chmurze w celu ujednolicenia modeli dostępu w środowisku hybrydowym lub dodatkowe usługi warstwy 7, które mogą mieć pozytywny wpływ.

Po ustaleniu tego kontekstu można zdefiniować podejście do definiowania polityki. Najlepszym sposobem, aby się tu dostać, jest przejrzenie spisu ważnych aplikacji i zapytanie, kto powinien mieć dostęp, co powinien być w stanie zrobić, skąd ten dostęp powinien być przyznany i jakie metody dostępu są prawidłowe lub nie, dla różnych powiązanych usług. Po udokumentowaniu tego możesz teraz określić, które wejścia lub sygnały mogą być użyte do podjęcia tych decyzji. Inteligentne moduły równoważenia obciążenia w połączeniu z innymi częściami ekosystemu, takimi jak system twojego dostawcy tożsamości, można następnie skonfigurować w taki sposób, aby wykorzystywały te dane wejściowe w procesie podejmowania decyzji. Ostatnim krokiem jest ostatecznie wprowadzenie modelu iteracyjnego i ciągłego doskonalenia. Jest to możliwe tylko dzięki solidnemu systemowi monitorowania, który pozwala wiedzieć, czy zamierzone wyniki, które miałeś, zostały faktycznie osiągnięte, lub czy realizowane są niezamierzone negatywne skutki, takie jak części twojego ekosystemu, które powinny mieć dostęp do chronionej aplikacji, mają go teraz blokowany.

Poza tym, właściwy rodzaj monitorowania jest ważny, ponieważ nie ma rozwiązania - poza brakiem połączenia z siecią - które może zapobiec wszystkim możliwym zagrożeniom. W rezultacie posiadanie systemów, które mogą zidentyfikować pozornie luźno powiązane wskaźniki wyprzedzające, aby uzyskać dostęp do naruszeń i pomóc w stworzeniu jasnego obrazu z perspektywy informatyki śledczej, ma również kluczowe znaczenie dla zapobiegania i skrócenia czasu do wykrycia / rozwiązania problemu.

Podstawowym kluczem do sukcesu jest rozpoczęcie od skupienia się na celach biznesowych do osiągnięcia przez Twoją organizację. To z kolei napędza konkretne podejście, które podejmiesz do oceny opcji i rozpoczęcia podróży z zerowym zaufaniem. Jednak obecny krajobraz bezpieczeństwa IT absolutnie wymaga innego podejścia do modeli, które były wcześniej wykorzystywane. Zacznij od przyjrzenia się temu, co już masz i jak można to rozszerzyć, abyś mógł zacząć wprowadzać niektóre z podstawowych zasad strategii zerowego zaufania. Posiadanie odpowiedniego modelu może pomóc Ci wyprzedzić złych aktorów, a także zachować przewagę konkurencyjną, zapobiegając niektórym problemom z bezpieczeństwem oraz umożliwiając szybsze wykrywanie innych problemów i reagowanie na nie.

Dowiedz się więcej o tym, co Kemp robi w przestrzeni zerowego zaufania i oceń naszą architekturę Zero Trust Access Gateway, odwiedzając dedykowaną stronę, z możliwością zgłoszenia chęci przetestowania rozwiązania Kemp ZTAG.

Oryginalna treść artykułu: https://kemptechnologies.com/blog/zero-trust-kemp/

Informacja o autorze artykułu:

Jason Dover

Dyrektor ds. Zarządzania liniami produktów w KEMP Technologies. Jason Dover jest ekspertem w dziedzinie technologii przesyłania wiadomości i dostarczania aplikacji, który ma doświadczenie w projektowaniu i wdrażaniu rozwiązań Enterprise Unified Communication & Directory. Obecnie jest członkiem zespołu ds. zarządzania produktami KEMP Technologies odpowiedzialnego za działania marketingowe w ramach portfolio produktów KEMP Technologies. Przed dołączeniem do KEMP Technologies, pracował w branży finansowej i świadczył usługi konsultacyjne w zakresie komunikacji i usług katalogowych oraz migracji dla NYSE Euronext i Deutsche Bank, a także pełnił funkcję kierownika technicznego w globalnym zespole ds. obsługi komunikacji i usług katalogowych w AllianceBernstein.

.....................................................................................

Zainteresowały Cię rozwiązania Kemp Flowmon ?

Zapraszam do kontaktu

Marceli Matczak

Security / SDN Business Development Manager

+48 785 051 978

marceli.matczak@s4e.pl